AI工作負載的運算密度極高,對運作所需的電力與能源需求也不斷攀升,這樣的趨勢未來只會更加明顯。從晶片設計的角度來看,有兩大部分會消耗最多電力:運算與資料傳輸。此外,還需要冷卻系統帶走這些運作所產生的熱量。

運算方面,AI依賴大量的乘加運算(multiply-accumulate),這需要在晶片中部署高效能、節能的運算結構。資料傳輸過程並不總是在同一個位置完成,許多情況下,AI模型的輸出需要進一步處理,這就需要資料在不同元件間移動,進而增加額外的能耗與功耗負擔。因此,最佳化各運算元件之間的通訊至關重要。這些元件可能在同一顆晶片中,也可能分佈在不同刀鋒伺服器甚至不同機架上。

冷卻系統的挑戰同樣嚴峻。為了降低延遲與功耗損失,設計上會將運算與記憶體單元緊密排列,但這也造成熱密度升高的問題。因此,發展高效率的冷卻解決方案是確保能源密度與硬體可靠性不可或缺的一環。

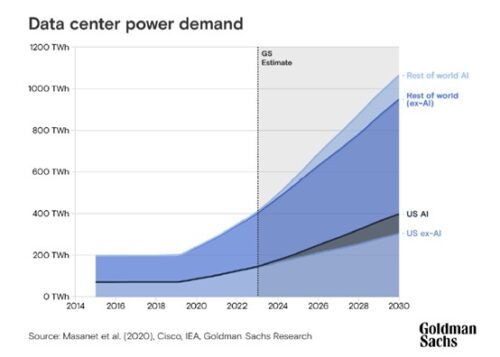

根據Goldman Sachs的研究,AI預計將推動資料中心電力需求增長160%。這個驚人的數字背後,反映的是全球AI競賽帶來的能源壓力。為了降低能源成本,晶片設計正積極整合最佳化記憶體階層與共同設計的通訊機制。這些方案可以降低資料傳輸次數,也能降低仍需傳輸資料所消耗的能量。當中運用了晶片堆疊、高頻寬記憶體(HBM)與先進互連技術等手段。AI框架與演算法也正朝著每瓦效能(performance-per-watt)與每成本效能(performance-per-cost)最佳化方向演進,協助在保持運算力的同時達到經濟永續性。

AI軍備競賽蠻力難持續 協同設計成破局關鍵

全球「AI主導權」競爭導致無止盡的訓練投資,但這種「蠻力法」在經濟上難以為繼,因此對更智慧、節能的晶片解決方案需求將大幅提升。目前全球正在進行一場「AI主導權」競爭,這導致大量資金投入,用以訓練愈來愈多、愈來愈大的AI模型。這些模型的訓練需要龐大的運算資源,並可能持續數月,且同時部署於數千個運算單元上。

然而,這種「蠻力」式的AI訓練方式並不具經濟可持續性,因此產業勢必會轉向更聰明、更節能的晶片解決方案。此外,每一次AI模型訓練失敗,都會造成運算資源與能源的浪費。要降低這種浪費,就必須從AI堆疊的每一層(從晶片到框架)進行大量最佳化工作。

好消息是,我們已看到更節能的晶片設計,以及體積更小、效能更高的AI模型出現。像是業界正推動的FP4(4位元浮點)資料型態與新指令集架構,就帶來了逐步的能效改善。同時,晶片正朝著晶片堆疊與3D封裝發展,這也使像小晶片(chiplet)這類架構成為更節能的選擇。此外,產業已證明:小型、高效率的AI模型是可行的。這些模型特別適合用於邊緣裝置上的生成式AI應用,不僅體積小、精度高,也更具可攜性。

人們常問:「是AI在影響晶片,還是晶片在驅動AI?」事實上,兩者是雙向互動的共生關係。已有不少案例顯示,AI模型的需求正主導晶片設計,資料科學家期待硬體能支援新的資料格式與模型架構,以驅動AI創新。為了滿足這些需求,晶片設計正持續調整,因為硬體限制將可能阻礙AI的發展。然而最大挑戰在於,硬體的開發週期往往需時多年,而AI世界則快速變化,像ChatGPT與Llama模型已短時間內歷經多次更新。

另一方面,底層架構的創新(如新指令集與功能)也可啟動AI發展的新契機。例如Arm持續推出像SVE2與SME(Scalable Matrix Extension)等功能,讓生態系具備更多AI能力。此外,如今的硬體也已適應transformer類模型的訓練需求,這些模型正是生成式AI的核心。理想狀況下,AI與晶片應採取「協同設計」的方式:硬體與演算法同步開發,以實現效能與效率的最佳平衡。

Arm攜手Meta 邊緣雲端雙軌並進

現今與未來的AI發展,都需要同時仰賴雲端與邊緣端的運算。兩者共同推進AI運算效率。邊緣推論將補足資料中心,讓部分推論任務在較低功耗下執行。透過智慧分配工作負載,整體系統效率得以提升。

隨著裝置上的運算能力提升,AI在邊緣的處理變得越來越普遍。這股趨勢由能夠在受限功耗環境下執行各種AI工作負載的晶片設計所推動,例如行動裝置。AI在邊緣處理能帶來電力與成本上的節省,因為它免除了裝置與雲端之間資料往返傳輸的需求。這樣的設計也透過將個人資料保留在本地,強化了隱私,同時降低延遲,有助於提供更快速的AI體驗。

邊緣AI的發展受到來自行動裝置與物聯網裝置等各式裝置的支持,這些裝置正在採用更小型、更具能源效率的AI模型。例如,Arm與Meta合作的最佳化工作,讓其Llama 3.2大型語言模型(LLM)能夠以史上最快的速度,在搭載Arm的行動裝置上執行。

對於資料中心而言,能源效率的AI更是不可或缺,尤其是在這些環境中處理著大規模的AI工作負載。產業界不可能完全移轉離開雲端,因為訓練大型AI模型的效能需求實在過高。因此,資料中心內的處理必須達到盡可能高的效率。在資料中心中,AI正被用來強化資源分配與冷卻能源的使用,協助推動更永續的運作。同時,AI演算法也被應用於最佳化資料中心內的作業,透過在管理工作負載時平衡功耗與效能來達成。此外,AI也被運用於系統監控,以降低故障與停機的機率。

軟硬協同創新 平衡永續與效能

實現AI的節能運算,是挑戰與機會交會的十字路口。硬體創新若能與軟體協同設計,將有望開創具永續性與可擴展性的AI解決方案。隨著邊緣與資料中心運算互補並進,未來的晶片技術將能完全發揮AI潛力,同時應對對電力效率的迫切需求。

從應用層面觀察,未來三年內將湧現更多「輕量級AI」的突破案例。醫療影像診斷晶片功耗可望降至5瓦以下,卻能提供相當於大型伺服器70%的準確度;自動駕駛系統的邊緣運算單元將在100瓦功耗限制下,達到Level 4自駕所需的即時推論能力。這些專用化模型不僅能大幅節約能源,更將催生全新的商業模式。

未來的關鍵,在於平衡功耗、效能與經濟可行性,並打造可隨技術演變而調整的硬體架構,讓AI革命在晶片上既具轉型性,又符合永續性。展望未來,AI的發展很可能走向高度專用的模型,例如針對醫學診斷或在地語音辨識等應用,這些模型能針對特定任務最佳化,在保持高效能的同時大幅降低能源消耗。

(作者為Arm機器學習工程副總裁)