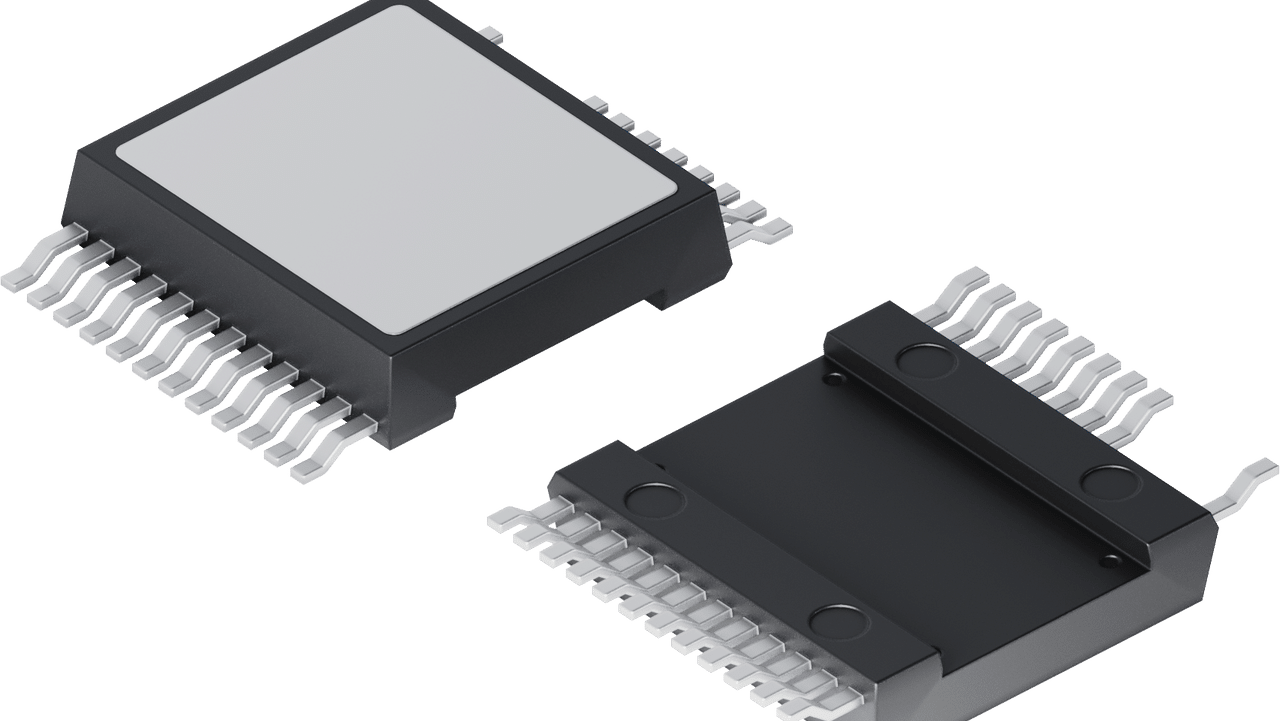

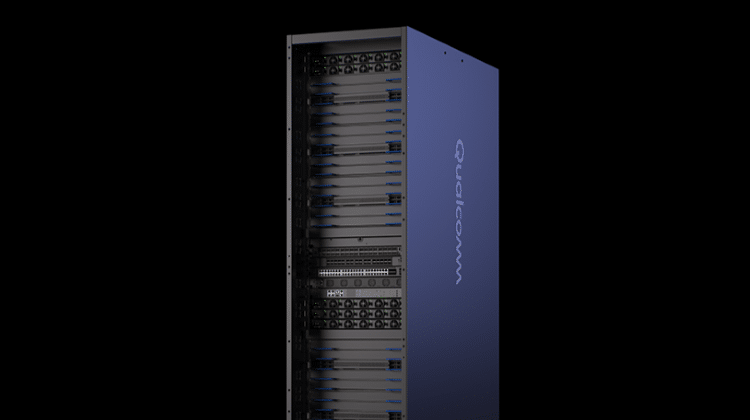

高通(Qualcomm)近日宣布推出新一代專為資料中心AI推論最佳化的解決方案:以高通AI200與AI250晶片為基礎打造的加速卡及機架系統。以高通在NPU技術領域的領導地位為基礎,這些解決方案提供機架級效能與卓越的記憶體容量,能以出色的每美元每瓦的高效能,支援快速生成式AI推論,並在推動跨產業可擴展、高效且靈活的生成式AI上邁出重大突破。

高通AI200推出專為機架級AI推論打造的解決方案,可為大型語言模型(LLM)、多模態模型(LMM)推論及其他AI工作負載提供低總體擁有成本(TCO)與最佳化的效能。每張加速卡支援768GB的LPDDR記憶體,實現更高容量與更低成本,為AI推論提供出色的擴展性與靈活性。

高通AI250解決方案將首次採用基於近記憶體運算(near-memory computing)的創新記憶體架構,透過提供超過10倍的有效記憶體頻寬並大幅降低功耗,為AI推論工作負載在效率與效能上帶來跨世代的躍進。此架構可實現分離式AI推論,提升硬體資源利用效率,同時滿足客戶在效能與成本上的需求。

兩款機架級解決方案皆配備直接液冷技術以提升散熱效率,支援PCIe垂直擴展與乙太網路橫向擴展,並具備機密運算功能以確保AI工作負載的安全性,而整個機架的功耗為160千瓦。

高通技術公司資深副總裁暨技術規劃、邊緣解決方案與資料中心總經理Durga Malladi表示,透過高通AI200與AI250,我們正重新定義機架級規模AI推論的可能性。這些創新的AI基礎架構解決方案能讓客戶以前所未有的總體擁有成本部署生成式AI,並兼顧現代資料中心所需的靈活性與安全性。我們擁有豐富的軟體堆疊與開放生態系統支援,讓開發者與企業能比以往更輕鬆地在我們最佳化的AI推論解決方案上整合、管理並擴展已訓練完成的AI模型。透過與主流AI框架的無縫相容性及一鍵式模型部署功能,高通AI200與AI250將支持企業輕鬆導入並加速創新。

我們超大規模等級的AI軟體堆疊,涵蓋從應用層到系統軟體層的端到端架構,並針對AI推論進行最佳化。此軟體堆疊支援主流的機器學習(ML)框架、推論引擎、生成式AI框架,以及包括分離式服務在內的大型語言模型(LLM)與多模態模型(LMM)推論最佳化技術。開發者可透過高通技術公司的Efficient Transformers Library與Qualcomm AI Inference Suite,無縫導入模型並一鍵部署Hugging Face模型。我們的軟體提供可立即使用的AI應用和智慧代理、完整工具、函式庫、API與AI營運化服務。

高通AI200與AI250預計將分別於2026年與2027年正式上市。未來,高通技術公司將致力於按年度迭代節奏,持續推動資料中心產品藍圖發展,專注於提供業界領先的AI推論效能、能源效率與最佳總體擁有成本。