登出中,將自動重新整理頁面

熱門關鍵字:

-

- 首頁

- 追新聞

- 懂市場

- 學技術

- 查圖表

-

探商情

-

馬斯克的軌道算力戰:從 Starlink V3 的魔改到 V4 的終極型態

2025 年 12 月 15 日 -

那些藏在展台裡的野心:ST 如何用 30 款方案重定義 AI 與移動的物理邊界

2025 年 12 月 15 日 -

Holtek推出HT66F3126/HT66F3132/HT66F3142三款全新A/D Flash MCU系列產品

2025 年 12 月 15 日 -

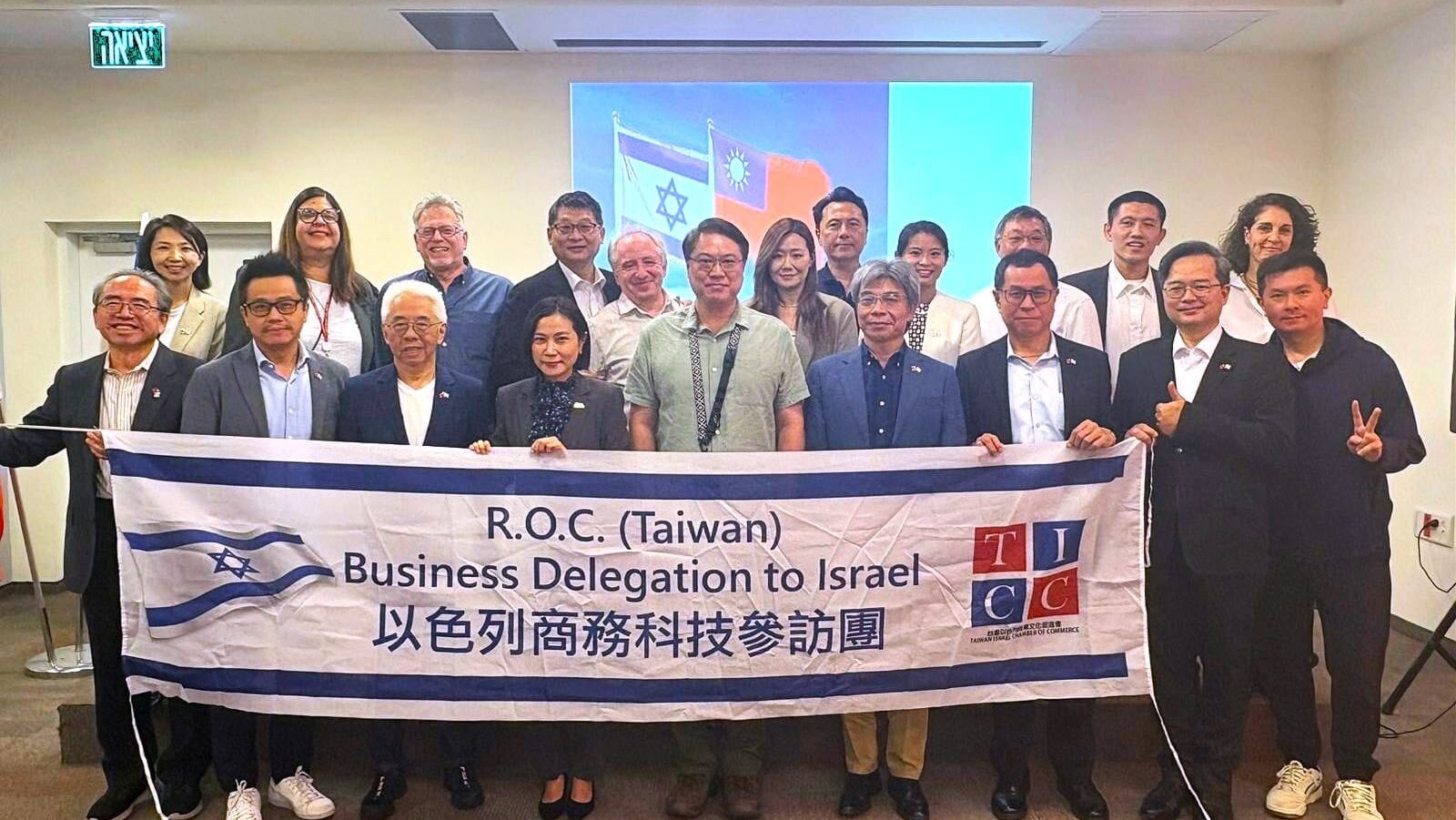

新唐科技參加台以商會座談會 分享跨國研發管理經驗

2025 年 12 月 15 日 -

Nordic Semiconductor推出nRF7002 EBII開發板 擴展nRF54L系列Wi-Fi 6功能

2025 年 12 月 15 日

-

- 研討會

- 找廠商

- 各期雜誌

- 白皮書

- 影音專區