美超微(Supermicro)宣布推出採用全新AMD Instinct MI350系列GPU的液冷與氣冷GPU解決方案。此解決方案透過最佳化設計,提供空前的效能,以及最大化的擴充性能和效率。Supermicro H14系列GPU最佳化解決方案搭載雙AMD EPYC 9005 CPU,以及AMD Instinct MI350系列GPU,專為尋求大規模式極致效能,同時需降低AI資料中心總體擁有成本的企業所設計。

Supermicro總裁暨執行長梁見後表示,Supermicro為AI和高效能運算應用提供高效能系統,並透過最豐富的相關經驗提供解決方案。我們的GPU伺服器產品系列採用了全新AMD Instinct MI350系列GPU,強化了我們的AI解決方案,並提供客戶更多元的選擇與更優越的效能。

Supermicro H14系列資料中心解決方案為各種AI、高效能運算、雲端和企業工作負載提供了空前的效能和靈活度。這些系統是基於經驗證的Supermicro建構組件架構,可助力企業客戶有效率地升級和擴大工作負載。

AMD董事長暨執行長蘇姿丰博士表示,與競品相比,AMD Instinct MI350系列提供的每美元Token數量可提升最高40%,同時維持符合產業標準的外型規格。這些GPU與Supermicro經驗證的平台結合後,可助力客戶基於完整AMD技術部署經完善整合的氣冷或液冷式機架,並提供高度的靈活性和效率。

Supermicro持續擴增經驗證的液冷和氣冷式高效能結構8-GPU系統機型,並透過開放式多架構產業標準OCP加速器模組(OAM)來支援最新的AMD Instinct MI350系列GPU。針對更高密度的運算環境,搭載AMD Instinct MI355X GPU的4U液冷系統則採用Supermicro經升級的全新直接液冷架構,具有可冷卻各種伺服器元件,並能降低最多40%耗電量的最新技術。

這些搭載AMD Instinct MI350系列的加速型GPU伺服器內,每個GPU具有288GB HBM3e,與前幾代AMD Instinct加速器相比,記憶體容量提高至1.5倍,頻寬也達到8TB/s。此外,FP16/FP8 petaflops則是提高至1.8倍,使客戶的AI工作負載能更快地處理更多資料。

ABI Research產業分析師Paul Schell表示,AI模型不僅在模型的規模方面持續擴大,也需要更快速、更有效率的基礎設施。Supermicro的最新H14解決方案採用了AMD MI350系列GPU,致力提供針對AI訓練和推論最佳化的高效能、高記憶體容量的可擴充式解決方案。

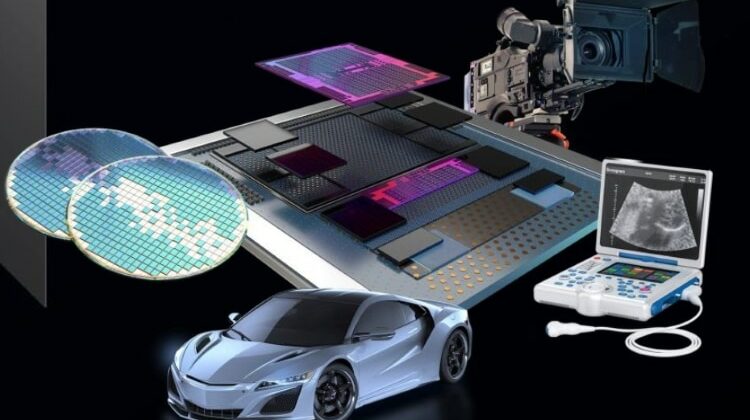

雲端服務供應商和企業合作夥伴能將此全新GPU解決方案運用在大規模AI技術應用上。AMD Instinct MI350系列採用第四代AMD CDNA架構,能針對AI訓練、推論,以及複雜的科學模擬等各種工作負載,提供優越的效能和能效。