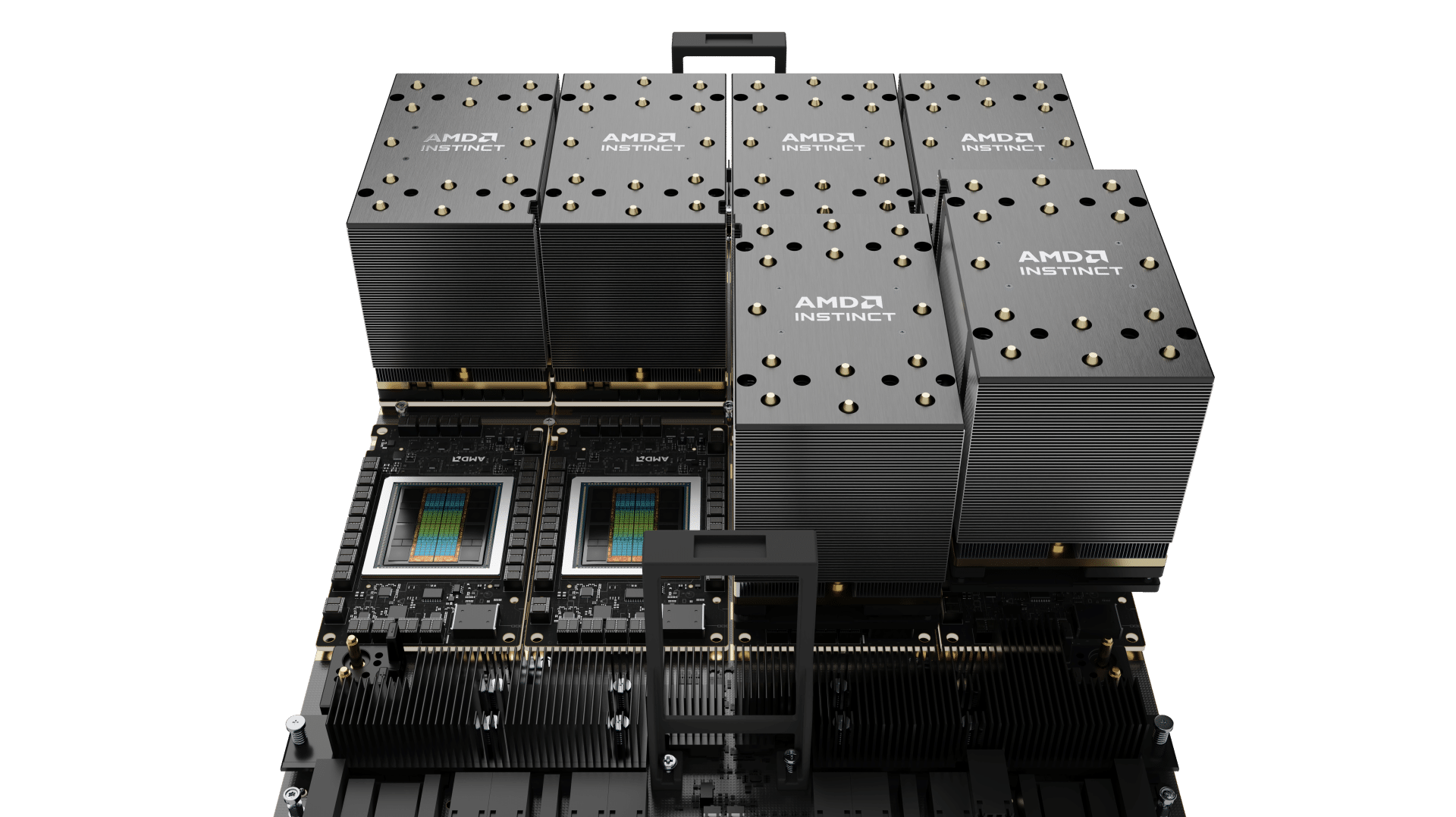

超微(AMD)宣布,Zyphra在大規模AI模型訓練方面達成重大里程碑,成功開發出ZAYA1,此為首個採用AMD GPU與網路平台訓練而成的大規模混合專家(MoE)基礎模型。這項成就得益於AMD Instinct MI300X GPU、AMD Pensando網路技術,並由AMD ROCm開放軟體堆疊所實現。

Zyphra測試結果顯示,該模型在推理、數學及編碼等基準測試中,與頂尖開放模型相比,展現出具有競爭力甚至更卓越的效能,充分彰顯AMD Instinct GPU在生產級AI工作負載方面的可擴展性與效率。

AMD人工智慧事業群人工智慧與工程全球副總裁Emad Barsoum表示,AMD在加速運算領域的地位,正為Zyphra等創新者挹注動能,持續突破AI領域的極限。這項里程碑展示了AMD Instinct GPU與Pensando網路技術在訓練複雜大規模模型方面的強大能力與靈活性。

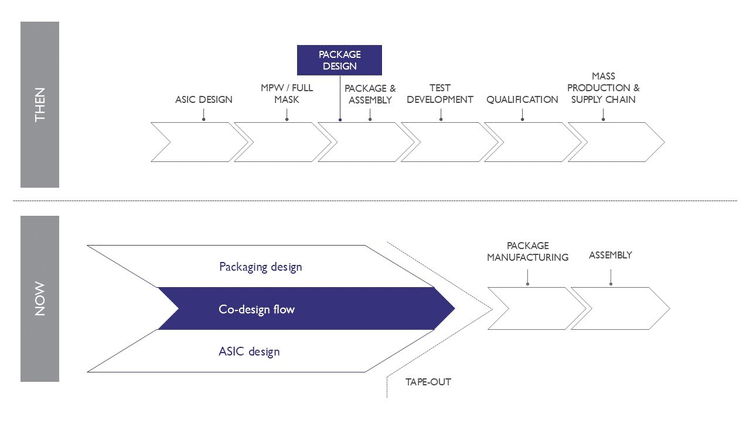

Zyphra執行長Krithik Puthalath指出,效率一直是Zyphra的核心指導原則,影響著我們如何設計模型架構、開發訓練與推論演算法,並選擇具備最佳性價比的硬體,以向客戶提供前瞻性的智慧。ZAYA1體現了這項理念,我們很高興成為首家在AMD平台上展示大規模訓練的公司。這個成果彰顯將模型架構與晶片及系統共同設計的強大力量,我們期待在建構下一代先進多模態基礎模型的進程中,深化與AMD及IBM的合作。

AMD Instinct MI300X GPU具備192GB高頻寬記憶體,實現高效的大規模訓練,無須仰賴成本高昂的專家或張量分片(Tensor Sharding),從而降低複雜度並提升整個模型堆疊的吞吐量。Zyphra亦指出,透過AMD最佳化的分散式I/O,模型儲存時間加快10倍以上,進一步提升訓練的可靠性與效率。ZAYA1-Base僅以極小部分的活躍參數,總參數量8.3B、活躍參數760M的效能,已可媲美甚至超越Qwen3-4B、Gemma3-12B、Llama-3-8B和OLMoE等模型。

基於先前的合作基礎,Zyphra與AMD及IBM緊密合作,設計並部署搭載AMD Instinct GPU及AMD Pensando網路互連技術的大規模訓練叢集。這套由AMD與IBM共同開發的系統已於本季稍早發表,結合AMD Instinct MI300X GPU與IBM Cloud的高效能網路與儲存架構,為ZAYA1大規模預訓練奠定基礎。