在數字通膨的年代,半導體產業往往陷入一種迷思:以為更大的數字就代表更好的體驗。當競爭對手紛紛將CPU、GPU與NPU的算力加總,喊出驚人的「總TOPS」數字時,高通產品管理副總裁Upendra Kulkarni在新一代Snapdragon方案技術論壇上,拋出了一個讓全場深思的比喻:「用GPU跑AI,就像開著一輛18輪的大卡車去送一個小包裹。」

這句話不僅是行銷話術,更是對AI PC發展分水嶺的精準判斷。對於追求極致圖形渲染的遊戲玩家或科學運算專家,耗油的猛獸或許是剛需;但對於那些渴望全天候智慧助理隨侍在側的廣大筆電使用者,他們真正渴求的不再是單純的暴力堆疊,而是一種代謝率極致精準的新物種。

預計搭載於下一代筆電的Snapdragon X2晶片(代號Project Glymur),正是高通對這場分眾市場的精準回應。這款晶片不只將NPU算力推升至80TOPS,更試圖用一種近乎強迫症的「精算師思維」,透過微米級的架構重組,重新定義什麼叫運算效率。

突破阿姆達爾定律 異質運算的指揮家

要理解X2的突破,得先聽聽Lucian的故事。這位在高通任職超過20年的技術副總裁,是Hexagon架構的始祖。他在演講中直言,AI工作負載具有極高的「異質性(Heterogeneity)」。若晶片設計只專注於堆砌矩陣運算(Matrix)的單元數量,系統最終會撞上「阿姆達爾定律(Amdahl’s Law)」的鐵壁。

簡單來說,無論你的運算核心(Tensor Core)有多快,整體處理速度最後都會被那些負責邏輯判斷、數據搬運的「慢速環節」給拖垮。就像你擁有一台法拉利引擎,卻裝在輪胎沒氣的車架上。為了打破這個瓶頸,X2的Hexagon NPU 6展現了一種「黃金三角」的協同架構設計,高通將其打造成一支分工精密的交響樂團。

首先是擔任「指揮家」角色的純量單元(Scalar)。在傳統認知裡,大家只在乎負責算數的工人(矩陣單元),卻忽略了發號施令的主管。但在代理式AI(Agentic AI)的推論過程中,大量的控制流(Control Flow)與條件判斷決定了數據該往哪裡走。X2將純量單元的硬體執行緒(Hardware Threads)從前代的6個直接翻倍到12個,這就像是讓指揮家長出了三頭六臂。這樣的設計是為了應對日益複雜的AI調度需求——當你的智慧助理需要同時處理語音辨識、畫面理解與文字生成時,純量單元能確保這些任務不會在排程上「打架」。更關鍵的是,配合擴展至64位元的記憶體位址空間,NPU能直接定址高達48GB甚至64GB的記憶體池。這意味著NPU不再需要像過去那樣依賴CPU把模型「切碎」餵給它,而是能一口氣吞吐整塊數據,從根本上消除了CPU介入所造成的延遲。

獨家微區塊技術 極大化頻寬利用

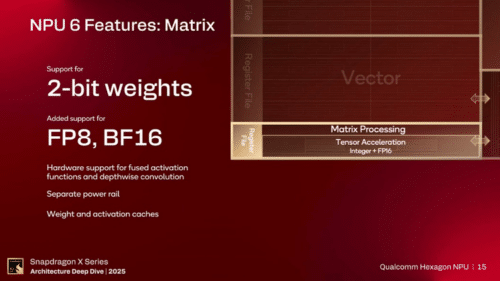

再來是負責通用運算的「樂手」——向量單元(Vector)。這部分升級了基於1024-bit的超寬SIMD(單指令多數據)暫存器,吞吐量大幅提升了143%。這主要針對的是Transformer模型中那些非線性運算的環節,例如Softmax層或LayerNorm的處理。在這裡,高通引入了其獨家的「微區塊推論(Micro-Tile Inferencing)」技術。這是一種極致的記憶體管理策略。

想像一下,傳統GPU在處理圖像或張量時,往往需要頻繁地去讀取外部的DRAM(動態隨機存取記憶體),這不僅慢,而且極度耗電。X2的向量單元能將大型張量切割成極小的「微區塊」,使其剛好能塞進NPU內部的SRAM(靜態隨機存取記憶體)中。這意味著所有的中間運算過程都在晶片內部的「高速緩存」中完成,數據不需要頻繁進出昂貴的外部記憶體匯流排。這種設計,是X2能在極低功耗下跑出高分數據的秘密武器。

導入分離式電源 拒絕暗矽浪費的精算

真正的重頭戲,在於負責重型運算的矩陣單元(Matrix)。這也是X2技術含金量最高的地方。高通在矩陣單元中引入了「分離式電源軌(Split Power Rail)」設計。在傳統處理器或GPU設計中,各個運算單元往往共享同一條電源軌。這就像是一個全屋只有一個總開關的房子,你要在書房開個小燈(進行輕量AI推論),卻被迫連客廳的冷氣(整個GPU核心)一起通電。這導致了嚴重的「暗矽(Dark Silicon)」浪費。

X2則為Hexagon NPU的矩陣引擎拉了獨立的供電線路與電壓調節器。這項技術細節的戰略意義在於,大型語言模型(LLM)的運作特性非常極端,分為「預填(Prefill)」與「解碼(Decode)」兩個階段。在預填階段,系統需要快速閱讀並理解使用者的長篇提示詞,這時運算量爆表,X2會拉高矩陣單元的電壓全速衝刺;但在解碼階段,也就是AI開始一個字一個字吐出答案時,瓶頸往往卡在記憶體頻寬而非運算能力,這時若維持高電壓純屬浪費。X2能根據當下的工作負載微調電壓,讓矩陣單元進入低功耗巡航模式。這種對每一毫瓦電力的外科手術式管理,讓它在5W的低功耗下,效能達到了前代的1.6倍。

軟硬整合再進化 重塑筆電選購標準

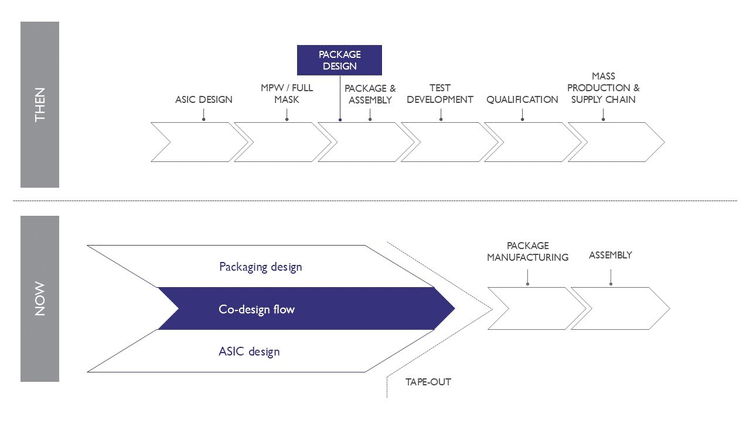

除了NPU本身的進化,X2在封裝技術上也迎來了類似Apple M系列與Intel Lunar Lake的重大變革:系統級封裝(SiP)。Project Glymur直接將LPDDR5X記憶體顆粒封裝在處理器基板上。這種物理距離的縮短帶來了兩個立竿見影的效果:更低的延遲與更高頻寬。對於AI來說,記憶體頻寬(Memory Bandwidth)往往比算力更重要,因為在生成式AI中,每一個Token的生成都需要遍歷整個模型權重。X2支援高達8533 MT/s甚至更高的記憶體速率,這條更寬、更短的高速公路,讓80TOPS的算力能夠真正被餵飽,而不是在高速公路上空轉等待數據運送車。

這樣的硬體大升級,最終是為了服務一個全新的目標:代理式AI(Agentic AI)。目前的AI多半還是你問我答的被動式聊天機器人,但未來的AI將是全時運行的主動代理人。它需要理解你的目標,主動拆解任務,甚至跨應用程式調用工具。這要求NPU必須具備極低的延遲與即時反應能力。

在演示中,X2處理Llama 3.28B模型的「首字延遲(TTFT)」幾乎是零延遲,這就是高通強調的「矽晶片的速度(Speed of Silicon)」。此外,X2原生支援了2bit與4bit的整數權重(Int2/Int4),與目前業界追求浮點數(Float16)精度的迷思背道而馳,卻極度務實。透過量化感知訓練,未來模型在低精度下依然能保持高準確度。

NVIDIA擁有強大的18輪卡車車隊,適合運送名為「訓練」與「重度創作」的巨型貨櫃;但在需要隨傳隨到、全天候待命的個人助理戰場上,高通X2這種精打細算的電動機車隊,或許才是最後能把快遞準時送到你手上的贏家。別再只看它極速能跑多快,得看它能在高效能的狀態下跑多久,以及它是否聰明到知道何時該全力衝刺,何時該優雅滑行。